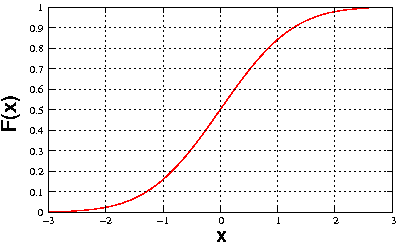

Fonction de répartition

En théorie des probabilités, la fonction de répartition, ou fonction de distribution cumulative, d'une variable aléatoire réelle X est la fonction FX qui, à tout réel x, associe la probabilité que X prenne une valeur inférieure ou égale à x :

Cette fonction est caractéristique de la loi de probabilité de la variable aléatoire. Elle permet de calculer la probabilité de chaque intervalle semi-ouvert à gauche ]a, b] où a < b, par

La fonction de répartition d'une mesure de probabilité définie sur la tribu borélienne est la fonction F qui à tout réel x associe

Exemples de calculs de la fonction de répartition

Variables à densité

La fonction de répartition FX d'une variable aléatoire X de densité de probabilité fX est une des primitives (en un sens un peu relâché, voir ci-dessous) de cette densité fX. Plus précisément, FX est définie, pour tout nombre réel x, par :

Toutefois, ce n'est pas, en toute généralité, une primitive au sens strict du terme : on peut seulement affirmer :

- qu'une fonction de répartition est dérivable presque partout (pour la mesure de Lebesgue) ;

- que si la variable X est à densité, alors la dérivée de FX est presque partout (pour la mesure de Lebesgue) égale à fX.

Mais il y a beaucoup de « contre-exemples » : la fonction de répartition de la loi uniforme sur un intervalle, ou encore celle de la loi exponentielle, ne sont pas dérivables sur tout et ne sont donc pas, au sens strict, des primitives de densités de probabilités.

Notons que, contrairement aux variables discrètes, une variable à densité X vérifie pour tout nombre réel a : en conséquence, la fonction de répartition des variables à densité est continue en tout point. En fait une variable aléatoire réelle X possède une densité de probabilité si et seulement si sa fonction de répartition est absolument continue sur chaque intervalle borné.

Variables discrètes

Une variable aléatoire X est dite discrète si son support S est fini ou dénombrable, ou bien, de manière équivalente, s'il existe un ensemble A fini ou dénombrable tel que :

La loi de X est déterminée sans ambiguïté par la donnée de (ps)s ∈ S ou de (ps)s ∈ A, où

Si, par exemple, X est une variable aléatoire réelle, on a

où 1E est la fonction indicatrice de l'ensemble E.

Pour les variables aléatoires discrètes les plus courantes (par exemple, les lois uniformes, binomiales, de Poisson) S est un ensemble bien ordonné : on peut alors numéroter ses éléments de manière croissante, p.e. s1 ≤ s2 ≤ s3 ≤ ... et numéroter les probabilités ps en conséquence, p.e. en posant pi = psi, i ≥ 1. On a alors, si x ∈ [si, si + 1[,

Soit encore, plus généralement :

La fonction de répartition est alors une fonction constante par intervalles et sa représentation graphique est en escalier. Les sauts d'une marche à l'autre de l'escalier se situent aux abscisses si, et l'amplitude du saut d'abscisse s est ps = FX(s) – FX(s–). En particulier la fonction de répartition d'une variable discrète X est discontinue exactement aux points s tels que Voir la section Propriétés de la fonction de répartition pour une démonstration.

Cas spécial : fonction de répartition continue purement singulière

L'escalier de Cantor F est un exemple de fonction de répartition continue mais dont la dérivée est presque partout nulle. Ainsi, les formules précédentes ne sont plus vraies pour l'escalier de Cantor : par exemple pour x > 0, on n'a pas

car F prend des valeurs strictement positives sur ]0, +∞[, alors que l'intégrale constituant le membre de droite est identiquement nulle. En effet, l'ensemble

est de mesure de Lebesgue nulle. Par ailleurs, la loi de probabilité associée à l'escalier de Cantor est diffuse (sans atome), puisque F est une fonction continue sur . L'escalier de Cantor est en fait un exemple de fonction de répartition continue mais qui n'est pas absolument continue sur chaque intervalle : on dit alors qu'elle est continue purement singulière.

Propriétés de la fonction de répartition

Propriétés caractéristiques

Théorème — La fonction de répartition FX d'une variable aléatoire réelle X a les propriétés caractéristiques suivantes :

- FX est croissante ;

- Elle est partout continue à droite ;

- Elle a pour limite 0 en , i.e. ;

- Elle a pour limite 1 en , i.e.

Le point 1 découle de la propriété de croissance des mesures de probabilité

Comme FX est une fonction monotone, le point 2 se réduit à montrer que

ou encore, équivalemment,

Mais les boréliens ]–∞ , x + 1/n[ forment une suite décroissante, et

donc le point 2 est une conséquence des axiomes des probabilités. Comme FX est monotone, le point 3 se réduit à montrer que

Ceci est encore une conséquence des axiomes des probabilités, puisque

Le point 4 découle, de la même manière, de

Réciproquement, toute fonction définie sur et satisfaisant ces quatre propriétés est la fonction de répartition d’une certaine variable aléatoire. Autrement dit, les points 1 à 4 sont caractéristiques de la fonction de répartition d'une variable aléatoire réelle X : étant donné une fonction réelle de la variable réelle, notons F, satisfaisant les points 1 à 4, on peut construire concrètement une variable aléatoire réelle X ayant F pour fonction de répartition, voir ci-dessous le théorème de la réciproque. Notons que la construction utilisant le théorème de la réciproque sert concrètement à produire, sur ordinateur, des échantillons de taille arbitraire d'une loi de probabilité arbitraire, ce qui est l'ingrédient de base des méthodes de Monte-Carlo.

Remarque

On peut ainsi définir la notion de fonction de répartition sans introduire celle de variable aléatoire : il suffit juste qu'elle vérifie les points 1 à 4 précédents. Si on ajoute à cela la notion de fonction arithmétique, on arrive rapidement dans la théorie probabiliste des nombres.

Autres propriétés

À cause des points 1, 3 et 4, FX est bornée, plus précisément

Comme toute fonction monotone bornée, FX admet en tout point x une limite à gauche FX(x–), limite à gauche égale ou non à FX(x) selon que FX est continue en x ou non. FX est une fonction càdlàg.

La connaissance de la fonction de répartition permet de calculer la probabilité de tout intervalle

et

- est la définition d'une fonction de répartition.

- on obtient par passage au complémentaire,

- pour on utilise pour A = ]–∞, x] et B = ]–∞, y],

- La relation est la plus délicate et fait intervenir une conséquence des axiomes des probabilités sur la probabilité de l'union d'une suite croissante d'ensembles. On considère une suite (xn) de réels croissante, convergeant vers x. L'intervalle ]-∞, x[ est alors union dénombrable de la suite croissante d'intervalles ]-∞, xn]. La probabilité de l'intervalle ]-∞, x[ est donc la limite des probabilités des intervalles ]-∞, xn], i.e. la limite de la suite FX(xn). Par propriété des fonctions croissantes, cette limite existe et vaut FX(x–).

Les 5 dernières propriétés découlent de pour différents choix de A et B :

On appelle atome de la variable aléatoire X tout réel a pour lequel . Ainsi, en vertu de la dernière propriété de la liste ci-dessus,

Propriété — Les atomes de la variable aléatoire X sont exactement les points de discontinuité de la fonction de répartition.

La fonction de répartition d'une variable aléatoire X est donc continue si et seulement si X n'a aucun atome, i.e. si et seulement si

On dit alors que la loi de X est diffuse, ou bien sans atome, et, par extension, que la variable aléatoire X elle-même est diffuse ou sans atome. En particulier, les variables aléatoires réelles possédant une densité de probabilité sont diffuses. Il existe cependant des variables aléatoires diffuses mais ne possédant pas pour autant une densité de probabilité, c'est le cas, par exemple, de la variable aléatoire ayant pour fonction de répartition l'escalier de Cantor.

Notons que l'ensemble des points de discontinuité de FX est fini ou dénombrable, comme c'est le cas pour toute fonction monotone bornée :

Conséquence — L'ensemble S des atomes de la variable aléatoire X est fini ou dénombrable.

Caractérisation de la loi par la fonction de répartition

Théorème — La loi de probabilité d'une variable aléatoire réelle est caractérisée par sa fonction de répartition.

Ou bien encore : si deux variables aléatoires réelles ont même fonction de répartition, alors elles ont même loi (et réciproquement).

Sous l'hypothèse FX = FY, on peut démontrer de manière élémentaire que dès que A est un borélien "simple" (par exemple, si A est un intervalle). Par contre, la démonstration générale (pour tout borélien A) est un cas particulier du lemme d'unicité des probabilités, lui-même corollaire du lemme de classe monotone, appliqué à la classe

Il faut vérifier que

- la classe est stable par intersection finie,

- la tribu engendrée par contient (et en fait est égale à) la tribu borélienne.

Le lemme d'unicité des probabilités permet alors de conclure.

Vérifions 1. Soit I une partie finie de . Soit y l'élément minimal de I. Alors

Vérifions 2. La tribu engendrée par est notée . La tribu borélienne est notée , comme souvent. Notons

On a en vertu de la stabilité des tribus par passage au complémentaire, donc par définition d'une tribu engendrée. On peut interchanger et dans ce qui précède, donc, par double inclusion,

Comme est une partie de l'ensemble des ouverts, on en déduit que

Mais il nous faut surtout démontrer l'inclusion en sens inverse, et, pour cela, démontrer que tout ouvert de est dans (ainsi est une tribu contenant tous les ouverts de , alors que est la plus petite tribu contenant tous les ouverts de ). Un argument rapide est de constater que

- tout ouvert de est réunion dénombrable d'intervalles ouverts, et que

- les intervalles ouverts sont dans .

Le premier point résulte de ce que

- un ouvert est réunion disjointe de ses composantes connexes (cela est vrai pour toute partie de ),

- les parties connexes de (et en particulier les composantes connexes ci-dessus) sont exactement les intervalles de

- comme est localement connexe, les composantes connexes d'un ouvert sont automatiquement ouvertes.

- dans chaque composante connexe A de notre ouvert , on peut choisir un nombre rationnel qA. Les qA sont distincts car les composantes sont disjointes. Ainsi A → qA est une bijection entre la famille des composantes connexes de et une partie de La famille des composantes connexes de est donc finie ou dénombrable.

Le deuxième point tient à ce que

- comme on l'a vu plus haut ;

- ;

CQFD

En d'autres termes, si deux variables aléatoires réelles, X et Y, vérifient

alors elles vérifient aussi que pour tout borélien A,

De plus, elles vérifient que pour toute fonction mesurable φ,

dès que l'un des deux termes de l'égalité a un sens.

Théorème de la réciproque

Soit F une fonction de dans satisfaisant les 4 propriétés caractéristiques. Notons G la fonction définie pour ω ∈ ]0, 1[ par

Alors G est une variable aléatoire réelle définie sur l'espace probabilisé où et où désigne la restriction à de la mesure de Lebesgue sur . Le théorème stipule que :

Théorème — Sur l'espace , la fonction de répartition de G est F.

Ainsi toute fonction F de dans satisfaisant les quatre propriétés caractéristiques est fonction de répartition d'une variable aléatoire réelle (de G, par exemple), ou encore d'une mesure de probabilité sur (de la loi de G, par exemple).

Pour ω ∈ Ω = ]0, 1[, notons

Donc G(ω) = inf Aω. À cause du point 4, , et à cause du point 3, Aω est bornée inférieurement, donc G est bien définie.

Commençons par un cas simple à titre d'entrainement :

- F est continue strictement croissante

Si F est continue strictement croissante sur , alors F est une bijection de dans ]0, 1[, et G est la réciproque de F (on peut s'en convaincre en traçant Aω à l'aide du graphe de F). À ce titre, G est continue et strictement croissante sur ]0, 1[, et en particulier G est mesurable (c'est donc une v.a.r.). On a, de plus,

donc

Ainsi

- Cas général

Dans le cas général, on a également

et on conclut donc exactement de la même manière que précédemment, mais la démonstration de l'équivalence ci-dessus est moins directe. Tout d'abord, pour ω ≤ ω', Aω' ⊂ Aω, et donc G(ω) ≤ G(ω'). Du fait que G est monotone, il résulte que G est mesurable.

On a, par définition de Aω et de G(ω),

La réciproque vient de ce que {G(ω) ∈ Aω}, i.e. {ω ≤ F(G(ω))}, ce qui, avec {G(ω) ≤ x} entraîne, par croissance de F, {F(G(ω)) ≤ F(x)} , et finalement {ω ≤ F(x)} . Supposons en effet que G(ω) ∉ Aω, et considérons une suite strictement décroissante (xn)n ≠ 0 d'éléments de Aω telle que

Par continuité à droite de F,

mais également, par définition de Aω,

ce qui conduit à G(ω) ∈ Aω, d'où une contradiction (démonstration largement reprise de Sidney Resnick, A Probability Path).

Remarques.

- Lorsque F est une bijection bicontinue d'un intervalle I dans ]0, 1[ (i.e. F est continue strictement croissante), G est tout simplement la réciproque de F (i.e. G ∘ F = IdI et F ∘ G = Id]0, 1[). Pour cette raison, G est parfois appelée réciproque généralisée de F.

- G est aussi appelée fonction quantile.

- L'intérêt pratique de ce théorème est développé dans l'article Méthode de la transformée inverse, ainsi que dans la section suivante.

Conséquences du théorème de la réciproque

Simulation de variables aléatoires réelles de loi arbitraire

- Si U désigne une variable aléatoire réelle uniforme sur [0, 1], alors X = G(U) a pour fonction de répartition F.

Ainsi dans tout langage de programmation possédant un générateur de nombres aléatoires, on peut simuler une suite de longueur arbitraire de v.a.r. indépendantes de même fonction de répartition F, pourvu que G soit connue : il suffit alors d'appeler ce générateur de manière répétée, et d'appliquer la fonction G aux nombres produits par ces appels répétés.

Exemples

| densité de probabilité | fonction de répartition | réciproque (généralisée) | code | |

|---|---|---|---|---|

| Loi de Cauchy | ||||

| Loi exponentielle | ||||

| Loi uniforme sur [a, b] | ||||

| Loi de Bernoulli | ||||

| Loi uniforme sur {1, 2, ... , n} | ||||

| Loi normale, Loi binomiale | comme il n'y a pas de formule suffisamment explicite pour la fonction de répartition, et encore moins de formule explicite pour la réciproque de cette dernière, le théorème est alors inopérant. | |||

La loi normale peut cependant être simulée, par la méthode de Box-Muller, à l'aide de deux variables aléatoires indépendantes suivant chacune une loi uniforme : si de manière indépendante alors suit une loi normale centrée réduite. L'établissement de ce résultat fait également appel au théorème de la réciproque.

On trouvera tout sur l'art d'engendrer des variables aléatoires de lois arbitraires, par exemple à l'aide de variables uniformes, dans Non-Uniform Random Variate Generation, édité chez Springer, disponible sur le web[1].

Autres conséquences du théorème de la réciproque

La réciproque généralisée de F est un exemple de v.a.r. dont la fonction de répartition est F, mais c'est un exemple privilégié. Ses utilisations sont nombreuses, allant de propriétés de l'ordre stochastique, à des propriétés de la distance de Wasserstein[2], en passant par le théorème de représentation de Skorokhod, voir section suivante.

Convergence en loi et fonction de répartition

Considérons une suite de variables aléatoires (Xn)n ≥ 0 (resp. une variable aléatoire X) définies sur des espaces probabilisés (resp. ) éventuellement différents, mais toutes à valeurs dans le même espace métrique (S, d). On dit que (Xn)n ≥ 0 converge en loi vers X si, pour toute fonction continue bornée de (S,d) dans ,

On a le théorème suivant :

Théorème — Dans le cas de variables aléatoires réelles (), notons (Fn)n ≥ 0, F les fonctions de répartitions de (Xn)n ≥ 0 et de X. Il y a alors équivalence entre les trois propositions ci-dessous :

- (Xn)n ≥ 0 converge en loi vers X,

- pour tout réel x en lequel F est continue, ,

- il existe un espace probabilisé , et, définies sur cet espace, des variables aléatoires réelles (X'n)n ≥ 0 et X' telles que, simultanément,

- X' a même loi que X,

- pour chaque n, Xn' a même loi que Xn,

- (X'n)n ≥ 0 converge presque sûrement vers X'.

L'implication 1.⇒3. reste vraie lorsque les variables aléatoires réelles sont remplacées par des variables aléatoires à valeurs dans un espace de Lusin (S , d), i.e. un espace métrisable assez général ( et en sont des exemples). L'implication 1.⇒3. porte alors le nom de théorème de représentation de Skorokhod.

Une structure possible pour la démonstration est 3.⇒1.⇒2.⇒3.

- 3. implique 1.

C'est le plus simple. Il faut démontrer que

ou bien, équivalemment,

Mais la continuité de f assure que f(Xn') converge presque sûrement vers f(X'). De plus, |f| étant borné, on a que

pour tout n. Le théorème de convergence dominée de Lebesgue peut donc être appliqué ici, et donne la conclusion voulue.

- 1. implique 2.

On utilise la famille de fonctions continues bornées définies par le graphe ci-contre. Elles vérifient, pour toute variable aléatoire réelle Y,

et en particulier

On remarque alors que, pour tout ε > 0,

et

En faisant tendre ε vers 0, on obtient

Ainsi, dès que x est un point de continuité de F,

- 2. implique 3.

Notons (Gn)n ≥ 0, G, les réciproques généralisées de (Fn)n ≥ 0, F. Pour le triplet , choisissons , et prenons pour la tribu des boréliens et la mesure de Lebesgue correspondantes (i.e. restreintes à ]0, 1[). Le choix de X'n = Gn, X' = G satisfait à 3.1. et à 3.2. en vertu du théorème de la réciproque. De plus, en conséquence de 2., (Gn)n ≥ 0 converge presque sûrement vers G.

Notes et références

- ↑ La version pdf (libre et autorisée) de (en) Luc Devroye, Non-Uniform Random Variate Generation, New York, Springer-Verlag, , 1re éd. (lire en ligne) est disponible, ainsi qu'un récit humoristique des démêlés de Luc Devroye avec son éditeur.

- ↑ [1]

Voir aussi

Articles connexes

- Variable aléatoire

- Convergence de variables aléatoires

- Convergence en loi

- Inégalité de réarrangement

- Fonction quantile

- Méthode de la transformée inverse

Portail des probabilités et de la statistique

Portail des probabilités et de la statistique

![{\displaystyle \mathbb {P} (X\in ]a,b])=\mathbb {P} (a<X\leq b)=F_{X}(b)-F_{X}(a)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cd1116262237a0b52e83f8a5d5bba742202ad8bf)

![{\displaystyle F(x)=\mathbb {P} (]-\infty ,x]).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5d73ac113ede549a6298b0cbc694792dfdecb8bf)

![{\displaystyle \{x\leq y\}\Rightarrow \{]-\infty ,x]\ \subset \ ]-\infty ,y]\}\Rightarrow \{\mathbb {P} _{X}(]-\infty ,x])\leq \mathbb {P} _{X}(]-\infty ,y])\}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/189c4d70a27bad436d692209c7dc677f58c38eb7)

![{\displaystyle \lim _{n}\mathbb {P} _{X}\left(\left]-\infty ,x+{\tfrac {1}{n}}\right]\right)=\mathbb {P} _{X}\left(\left]-\infty ,x\right]\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f217968f702b5726d0a4e879aee3e5399e1209f4)

![{\displaystyle \bigcap _{n\geq 1}\left]-\infty ,x+{\tfrac {1}{n}}\right]\ =\ \left]-\infty ,x\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c185613bdd99b9b1d46a56fb4770ab1e7e67c4fa)

![{\displaystyle \bigcap _{n\geq 1}\left]-\infty ,-n\right]\ =\ \emptyset .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c65e66c7dd81938792a137daef91c965eff3d0dd)

![{\displaystyle \bigcup _{n\geq 1}\left]-\infty ,n\right]\ =\ \mathbb {R} .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1c94867dbaa431ea076ba610d9161f245fdb8869)

![{\displaystyle \mathbb {P} (X\in ]-\infty ,x])\,=\,\mathbb {P} (X\leq x)\,=\,F_{X}(x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fa1b49f45f0d7c775da30019ec63fce7df9a58ae)

![{\displaystyle \mathbb {P} (X\in ]x,+\infty [)\,=\,\mathbb {P} (X>x)\,=\,1-F_{X}(x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/01cb06969d07fb458ab0e358e93519bf91b7d944)

![{\displaystyle \mathbb {P} (X\in ]x,y])\,=\,\mathbb {P} (x<X\leq y)\,=\,F_{X}(y)-F_{X}(x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f1655be6d4f0f9d21858d82f025543154ea0eb54)

![{\displaystyle \mathbb {P} (X\in ]-\infty ,x[)\,=\,\mathbb {P} (X<x)\,=\,F_{X}(x_{-}),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ee672e8e34b129f9f5b2ba7982ab8e8f47a44b7c)

![{\displaystyle \mathbb {P} (X\in ]x,y[)\,=\,\mathbb {P} (x<X<y)\,=\,F_{X}(y_{-})-F_{X}(x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6eeeb2486b1d0b15076fce8439898c6c4b579b3d)

![{\displaystyle \mathbb {P} (X\in [x,y])\,=\,\mathbb {P} (x\leq X\leq y)\,=\,F_{X}(y)-F_{X}(x_{-}),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a56b1b3d11151b90c71ed1c4936e19daab945e3e)

![{\displaystyle \ \mathbb {P} (X\in ]-\infty ,x])\,=\,\mathbb {P} (X\leq x)\,=\,F_{X}(x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e4e3fca8bb8b22a31852e4c5d6b2fc21eded4945)

![{\displaystyle \ \mathbb {P} (X\in ]x,+\infty [)\,=\,\mathbb {P} (X>x)\,=\,1-F_{X}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3681fb8b89952b9d136f1ced0eced1f7c43998f4)

![{\displaystyle \mathbb {P} (X\in ]x,y[)\,=\,\mathbb {P} (x<X<y)\,=\,F_{X}(y_{-})-F_{X}(x),\ {\textrm {pour}}\ A=]-\infty ,x],\quad \ B=]-\infty ,y[,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/14e7ac977fea73f7b72e241eccf545b0b07decc3)

![{\displaystyle \mathbb {P} (X\in [x,y[)\,=\,\mathbb {P} (x\leq X<y)\,=\,F_{X}(y_{-})-F_{X}(x_{-}),\ {\textrm {pour}}\ A=]-\infty ,x[,\quad \ B=]-\infty ,y[,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2be46f979765123e8153088a4a4239b40b884eaf)

![{\displaystyle \mathbb {P} (X\in [x,y])\,=\,\mathbb {P} (x\leq X\leq y)\,=\,F_{X}(y)-F_{X}(x_{-}),\ {\textrm {pour}}\ A=]-\infty ,x[,\quad \ B=]-\infty ,y],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f1bfecdd92cb3b5379ab203d6f74042107679b16)

![{\displaystyle \mathbb {P} (X=x)=F_{X}(x)-F_{X}(x_{-}),\ {\textrm {pour}}\ A=]-\infty ,x[,\quad \ B=]-\infty ,x].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8f2c3dedcde60ccc4578b8bcc418f83be3cff027)

![{\displaystyle {\mathcal {C}}=\left\{]-\infty ,x]\ |\ x\in \mathbb {R} \right\}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/02507e15cbc92b57b6db96e7169f1a9a14a25295)

![{\displaystyle \bigcap _{x\in I}]-\infty ,x]\,=\,]-\infty ,y]\ \in \ {\mathcal {C}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6905dee2b6d1b5cd6c88e85a0d6c1676aaea8de)

![{\displaystyle {\mathcal {D}}=\left\{]x,+\infty [\ |\ x\in \mathbb {R} \right\}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a74a51661463c4bd49f0fca29afbb33e93f0414e)

![{\displaystyle \forall x\in \mathbb {R} ,\qquad ]x,+\infty [\ \in \ \sigma ({\mathcal {C}}),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e14f9e04bcc011f6cac845a3745c2c28f835f2c9)

![{\displaystyle \forall y\in \mathbb {R} ,\qquad ]-\infty ,y[\ =\ \bigcup _{n\geq 1}\ \left]-\infty ,y-{\tfrac {1}{n}}\right]\ \in \ \sigma ({\mathcal {C}})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/46a3ab95db0c525d021259d17740034f8af11efb)

![{\displaystyle \forall x<y\,\in \ \mathbb {R} ,\qquad ]x,y[\ =\ ]-\infty ,y[\,\cap \,]x,+\infty [\ \in \ \sigma ({\mathcal {C}}).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/31b342a79b67ba406b41cd538ac84b61b9c0130a)

![{\displaystyle \mathbb {E} [\varphi (X)]=\mathbb {E} [\varphi (Y)],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/14c57d3b21aa45f73e87484234e3cbedfd017f15)

![{\displaystyle \left(\Omega ,{\mathcal {A}}\right)=\left(]0,1[,{\mathcal {B}}(]0,1[)\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ead73c79933fde0cedcedafc8eb9ca5357a674f8)

![{\displaystyle {\mathcal {B}}(]0,1[)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/91b00fe5e05dcc38c3b656f566e2c3e9fd3a3882)

![{\displaystyle {\begin{aligned}\left\{\omega \in \Omega \ |\ G(\omega )\leq x\right\}&=\left\{\omega \in \Omega \ |\ \omega \leq F(x)\right\}\\&=]0,F(x)].\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/15261868a8acc19c0dee2091e9b10b847941046b)

![{\displaystyle \mathbb {P} \left(G\leq x\right)=\mathbb {P} (]0,F(x)])=F(x).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88b7e8fc59fb5d9d374c4313166df3c77a7844cb)

![{\displaystyle {\frac {1}{b-a}}\ 1_{[a,b]}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a729cd1b911cd4bea7ce8c5a2ecfb549596355fb)

![{\displaystyle F(x)={\frac {x-a}{b-a}}\ 1_{[a,b]}(x)\ +\ 1_{]b,+\infty [}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4f9bb0bd7f160d305bc9b170f28872a366e02f5)

![{\displaystyle F(x)={\frac {\lfloor x\rfloor }{n}}\ 1_{[0,n]}(x)\ +\ 1_{]n,+\infty [}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ac59aee661fc21481294415c1e5c0a4290b5e00)

![{\displaystyle U,V\sim {\mathcal {U}}([0,1])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/28a457c110176c25359304cdf57bba197d2cedaa)

![{\displaystyle \lim _{n\rightarrow \infty }\mathbb {E} \left[f(X_{n})\right]=\mathbb {E} \left[f(X)\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2fe2035f20355423040b58d07a2caea5a8d836eb)

![{\displaystyle S={\mathcal {C}}([0,1],\mathbb {R} )}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a5c9512a09b209fc3268586a1fc0d4eb4376da9a)

![{\displaystyle \lim _{n\rightarrow \infty }\mathbb {E} \left[f(X_{n})\right]=\mathbb {E} \left[f(X)\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/192a57346db1c48690191976183265bd32906070)

![{\displaystyle \lim _{n\rightarrow \infty }\mathbb {E} \left[f(X_{n}^{\prime })\right]=\mathbb {E} \left[f(X^{\prime })\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19f2d4cacf977168b0eb9985165e3ba6bfbc2aec)

![{\displaystyle \mathbb {P} \left(Y\leq a\right)\leq \mathbb {E} \left[\varphi _{a,b}(Y)\right]\leq \mathbb {P} \left(Y\leq b\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0b73501bf3433e5169b9b93f74fdc76e6f65e03a)

![{\displaystyle \mathbb {E} \left[\varphi _{x-\varepsilon ,x}(X_{n})\right]\leq F_{n}(x)\leq \mathbb {E} \left[\varphi _{x,x+\varepsilon }(X_{n})\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/208e249d6be743d2836288c27305b707ab1235af)

![{\displaystyle {\begin{aligned}\limsup _{n}F_{n}(x)&\leq \lim _{n}\mathbb {E} \left[\varphi _{x,x+\varepsilon }(X_{n})\right]\\&=\mathbb {E} \left[\varphi _{x,x+\varepsilon }(X)\right]\leq \mathbb {P} \left(X\leq x+\varepsilon \right)=F(x+\varepsilon ),\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dedf1fe615c177b4acbed62d00cfcd093a0de494)

![{\displaystyle {\begin{aligned}\liminf _{n}F_{n}(x)&\geq \lim _{n}\mathbb {E} \left[\varphi _{x-\varepsilon ,x}(X_{n})\right]\\&=\mathbb {E} \left[\varphi _{x-\varepsilon ,x}(X)\right]\geq \mathbb {P} \left(X\leq x-\varepsilon \right)=F(x-\varepsilon ).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d57efe7e95eb878e1021a135d79c3973b620c02a)

![{\displaystyle {\widehat {\Omega }}=]0,1[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/68430d3475f6d8adf79b8a7ca58d447cc132636d)